Please select your location and preferred language where available.

AIを支えるストレージソリューション

生成AIの市場は急速に拡大・成長し、自然言語処理や画像生成技術を用いた自動化ソリューションをはじめ、さまざまな業界において革新的なブレークスルーをもたらしています。

企業が競争力を維持するためには、データの増加や処理速度の要求に対し、AIモデルの高速かつ効率的なデータ処理が重要で、そのためには、データストレージやメモリソリューション技術の活用が不可欠です。生成AIは従来の学習から新たな推論フェーズに突入し、ストレージの大容量化、高速化はますます不可欠になっていきます。

キオクシアはフラッシュメモリやSSD製品とそれらを活用した技術で、AIに関する積極的な研究開発や技術提供を長年にわたって行い、産業界への貢献を通じて利便性の高い世界の発展に長期的に取り組んでいます。

AI(人工知能)とは?

AIは、機械にルールや膨大なデータを学習させることにより、従来は人間の知能で処理していたタスクを実行することを可能にするコンピュータ技術です。従来のAIは、学習したデータをもとに画像や音声を認識し、分析することで結果を予測するなど、あらかじめ決められた行為を自動的に行うものです。生成AIもAIのひとつで、生成という言葉が示す通り、ディープラーニングによってAI自らが学習を重ね、人間が与えていない情報やデータさえも自らインプットし、新しいコンテンツを生み出すことができます。

AIのワークロードとストレージ要件

AIシステムでは、異なるAI機能を実行するためのデータ収集、変換、学習、推論などのフェーズがあり、対応するワークロードがあります。これらのワークロードは、システムの中核であるGPU、CPU、ホストメモリに加え、データストレージ(SSDやハードディスクなど)に対して要求を行います。データストレージは、これらのさまざまなワークロードに応じて、要求を満たす必要があります。

データ収集

収集した大量のデータをストレージに保存する

学習用データ作成

学習の前処理として、データの分類、ラベル付け、データ加工などを行う。

ストレージは整形されたデータを保存し、GPUサーバーへ転送する。ストレージには大容量、高スループット(シーケンシャルリード)が必要になる。

学習/評価

AIアルゴリズムにより結果の評価、精度の向上のための改良を行う。

ストレージは中間結果の保存や学習データをキャッシュとして保存する。障害や演算ミスが発生した際に、最初からやり直さないようにスナップショットの保存が行われており、その出力時にはGPUを止める必要があるため、短時間で完了させる高スループットが必要になる。

推論

完成したモデルが、新しいデータを認識し結果をアウトプットする。

学習後に追加・更新されたデータや、秘匿性の高い情報は、別のデータベースに保存され活用されていく。ストレージには大容量、高スループット(ランダムリード)が必要となる。

キオクシアのこれまでのAIへの取り組み

キオクシアは、長年にわたってAIに関する研究開発を行っています。

1. AIを導入した自律型工場

「BiCS FLASH™」をはじめとするフラッシュメモリは、先端技術の粋を集めたスマートファクトリーで作られています。製造装置、検査装置から集まるビッグデータを収集します。それらをディープラーニングをはじめとするAI技術で解析、生産性向上につなげる技術を駆使しています。

2. 検索を使ったAI「記憶検索型AI」の研究開発

大規模言語モデルと検索を組み合わせたシステムを構築・評価する仕組みに関する研究成果を発表しています。

AI市場の見通しとデータストレージ 〜推論時代へ突入した生成AIへの対応〜

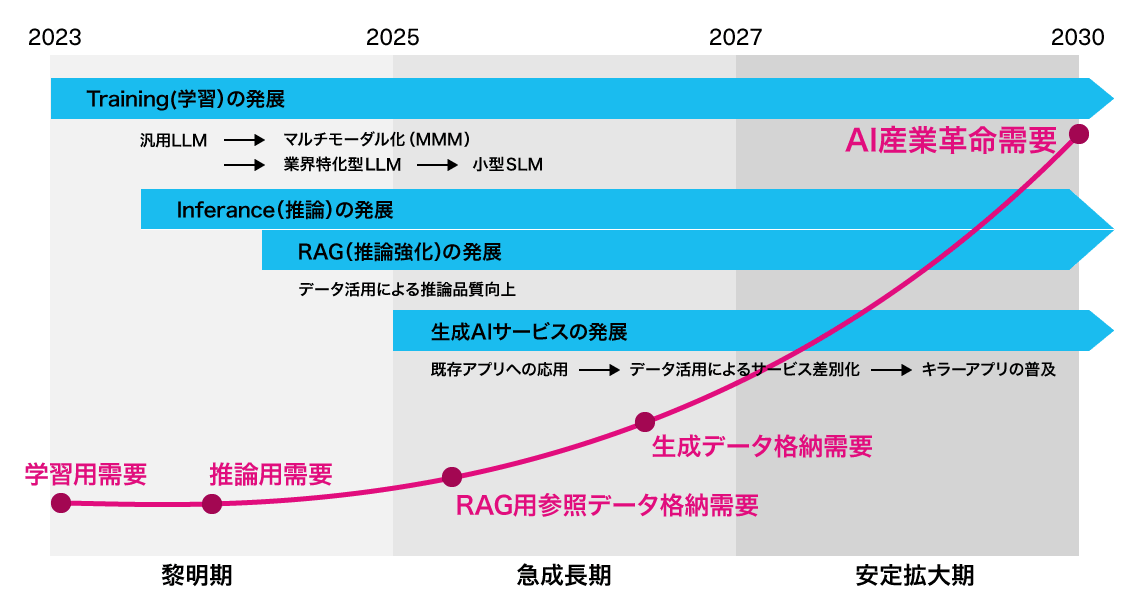

2022年末に登場し、世界的な注目を集めたLLM(Large Language Model:大規模言語モデル)は、学習と推論の分野で、テクノロジーを駆使したビジネスを展開している企業、いわゆるテック大手企業による一大ムーブメントを引き起こし、生成AIの黎明期をけん引しました。LLMが提供するサービスはさまざまなビジネスモデル、産業、そして社会に浸透すると期待されています。

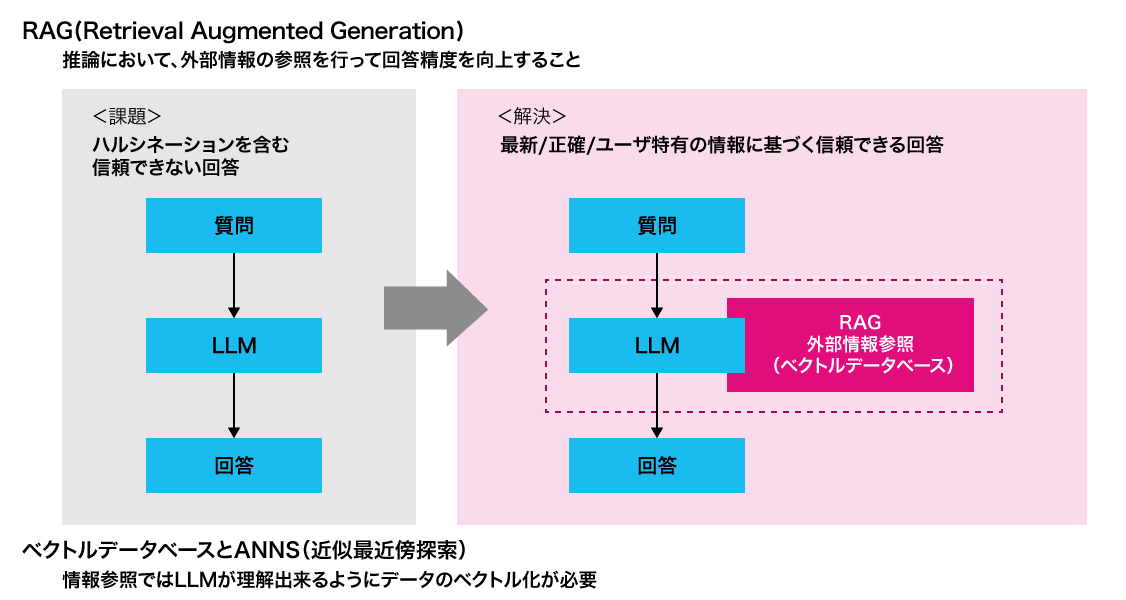

推論のさらなる発展に向け、推論の効果を最大化するための新たなアプローチとしてRAG(Retrieval-Augmented Generation:検索拡張生成)と呼ばれる技術が登場しています。

生成AIシステム(学習/推論)におけるSSD(ストレージ)の活用

この生成AIの発展にとって欠かすことのできない要素がデータです。不揮発性、大容量、高速という特長を持つSSDは、そのデータを保管する手段としてますます重要になっています。SSDは生成AI発展のステージに応じて進化し、その結果SSDの需要は急速に拡大しています。2024年から2030年にかけて、SSDの市場は容量ベースで約40~50倍に急成長すると予測されています。

キオクシアは、2030年までの中長期において、生成AIの市場は以下の4つのトレンドによってけん引されていくと考えています。

- 学習の発展

- 推論の発展

- 推論強化のためのRAGの発展

- 生成AIサービスの発展

このすべてのトレンドにSSDは極めて重要な役割を果たしていくと考えられています。

ハードウェア視点でのSSDの利点

生成AIシステムでは学習においても推論においても高価なGPUを使用します。生成AI処理に必要な大量のデータを揮発性のDRAMのみでまかなうことは困難なため、不揮発性のストレージデバイスから、学習用のデータ供給、推論時のRAG用のデータ参照、生成されたデータの保存といったデータ処理が必要です。

この時ストレージデバイスに求められる重要な条件は、高価なGPUをサポートするうえでGPUの稼働率を最大化するとともに、大きな電力・スペース効率を実現することです。この条件を満たすデバイスがSSDです。大容量といえばハードディスク(HDD)が思い浮かびますが、メディアの回転待ちや読み書きのヘッドの移動という機械的な構造上の制約があり、SSDに比べ100倍以上の読み書き遅延や、電力効率にも影響を及ぼします。今後ますます進む大容量化を支えながら、高性能なGPUの処理効率を最大化するという観点では、SSDはAIサービスのストレージを支えていく重要なデバイスなのです。

推論需要でのSSDの利点

LLMは、翻訳、文書要約やプランニングなど多様な分野で活用されるようになり、業務効率化や生産性向上を目的として多くの企業で既に利用が始まっています。

一方で、LLMが保有する知識は学習時に利用したデータに限定され、最新の情報や企業の機密情報・非公開情報などに基づく質問や指示に対しては正しい結果を生成することができません。これは幻覚(ハルシネーション)と呼ばれ、LLMの課題の一つです。

この課題を「LLMの外部に用意した知識データ」を用いて解決するのがRAGです。RAGでは、ベクトルデータベースと呼ばれるベクトルの類似度に基づいたデータ検索機能(ベクトル探索)を備えたデータベースソフトウェアを利用します。多くの企業がRAGに注目する最大の理由は、非公開の情報を活用しながら、LLMの高い性能を引き出せる点です。

RAGにおいて、知識データの中から問い合わせのベクトルに最も近いベクトルと対応するデータを見つけ出そうとした場合、数百次元から数千次元もの高次元ベクトル同士の類似度を計算することになります。これは、最新のAIサーバー計算機でも負荷がかかる大変な処理です。このため、近似最近傍(ANN:Approximate Nearest Neighbor)探索と呼ばれる、比較するベクトルを一部に絞り込むようなインデックスを用い、近似解を求める方式が一般的です。

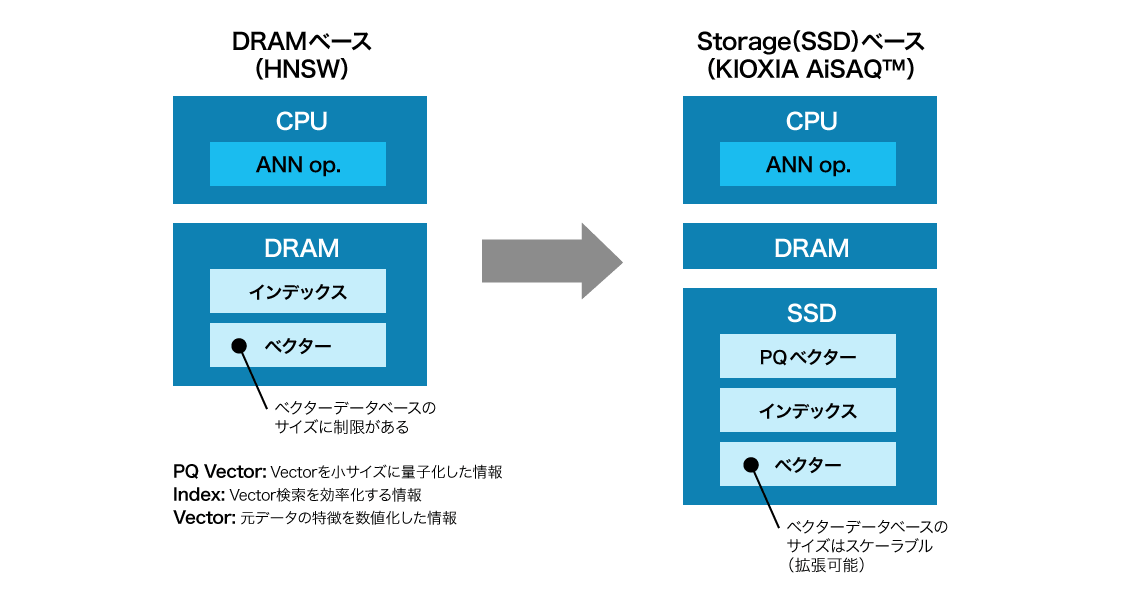

このANN探索には、DRAMベースのHNSW(Hierarchical Navigable Small World)方式、多くをストレージベースとしたMicrosoft社が開発したDiskANN方式など、さまざまな方式があります。ベクトルとインデックスをDRAMに展開するHNSW方式が多く利用されていますが、扱えるベクトル数、つまり知識の量がサーバーのDRAMサイズに制限されるため、大量の知識を基にしたRAGシステムを構築する足かせとなります。

キオクシアは、特に大きな成長が見込まれている生成AI市場でSSDをさらに活用する重要なストレージ技術として、新たな方式のストレージ(SSD)ベースである「KIOXIA AiSAQ™」の研究開発を進めています。

キオクシアが開発するAIイノベーション「KIOXIA AiSAQ™」

KIOXIA AiSAQ™は、All-in-Storage ANNS with Product Quantizationの略で、その名が示す通り、データの特徴を量子化した情報(PQデータ)を「オールインストレージ(すべてをストレージ)」に移行させ、RAGにおけるベクトル探索処理を行うためのANN探索の検索アルゴリズムを最適化するソフトウェアです。キオクシアは、このソフトウェアをオープンソースとして公開し、より高品質な生成AIアプリケーションの実現に寄与します。

通常、ベクトル探索を効率化するためにインデックス化されたデータはDRAM上に配置されますが、KIOXIA AiSAQ™はインデックス化されたデータをSSDに配置する技術です。

精度の高い回答(クエリ)には、RAGに使われるベクトルデータベースのサイズが更にスケールアウトしていくと予測されています。DRAMベース方式では、データベースサイズが大きくなるほど、膨大なDRAMが必要になります(左グラフ)。また、性能という観点でも、最適化されたストレージ(SSD)ベースの探索により、DRAMベース方式の探索よりも回答(クエリ)の精度と回答時間が上回ることが確認されています。

この革新的な技術は、RAGに使われる高価なDRAMに替えて、比較的安価なSSDのみを使用しつつ、性能を損なうことなくANNSを実現できる点で有望と言えます。

KIOXIA AiSAQ™ ソフトウェア ダウンロード

KIOXIA AiSAQ™はオープンソースソフトウェアです。GitHubからダウンロード可能です。

GitHub:

AI市場を支えるキオクシアの製品

AI市場の発展に伴うデータ量の爆発的増加に対応するキオクシアのエンタープライズ・データセンター製品を紹介します。

- 記憶容量:1 MB (1メガバイト) =1,000,000 (10の6乗) バイト、1 GB (1ギガバイト) =1,000,000,000 (10の9乗) バイト、1 TB (1テラバイト) =1,000,000,000,000 (10の12乗) バイトによる算出値です。しかし、1 GB=1,073,741,824 (2の30乗) バイトによる算出値をドライブ容量として用いるコンピューターオペレーティングシステムでは、記載よりも少ない容量がドライブ容量として表示されます。ドライブ容量は、ファイルサイズ、フォーマット、セッティング、ソフトウェア、オペレーティングシステムおよびその他の要因で変わります。

- NVMeはNVM Express, Inc.の米国またはその他の国における登録商標または商標です。

- PCIe は、PCI-SIG の登録商標です。

- その他記載されている社名・製品名・サービス名などは、それぞれ各社が商標として使用している場合があります。