Please select your location and preferred language where available.

ディープラーニングでは、ニューラルネットワーク内のパラメータを調整する学習という処理により、様々な知識や能力をニューラルネットワークに習得させることができます。一方で、学習が完了した後でユーザが新たにデータ(例えば画像)を入手し、そのデータに関する新たな知識をニューラルネットワークに追加で習得させたい場合、学習をやり直す必要があります。学習を一からやり直すには時間や消費電力のコストが大きくなる問題があります。そこで、新しいデータを含む一部のデータのみを使って学習をやり直す方法が考えられますが、古いデータで学んだ知識や能力を失う破滅的忘却という問題が避けられませんでした。

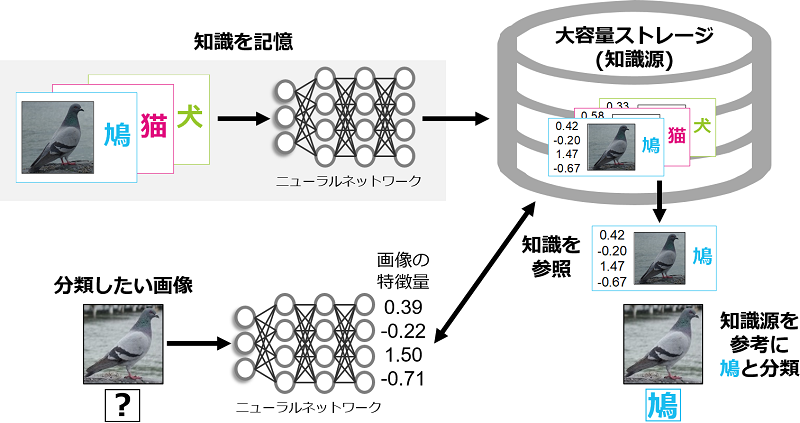

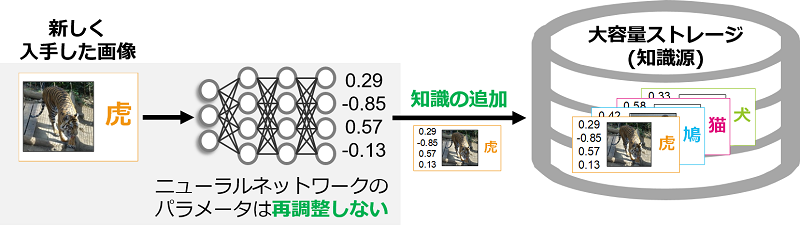

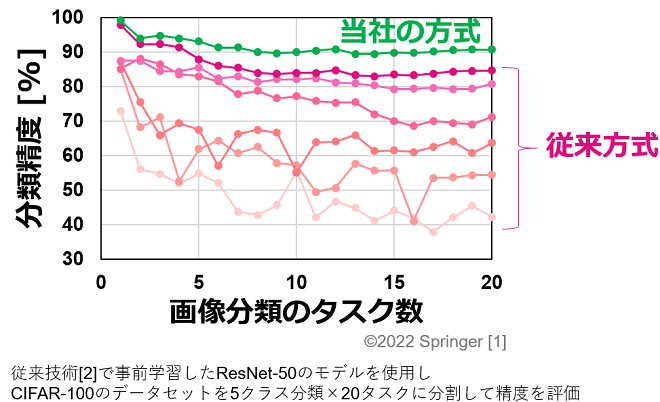

我々は当社の持つ大容量ストレージを活用したAI技術(記憶検索型AI)を利用し、画像分類タスクにおける破滅的忘却の問題の解決に取り組みました。具体的には、大容量ストレージに大量の画像データ、ラベル、画像の特徴量*1などの情報を知識として記憶しておき、画像を分類する際にストレージに記憶した知識を参照する方式を検討しました(図1)。この方式では、ユーザが新たに画像を入手した際に、学習(パラメータの調整)のやり直しをせず、画像の特徴量やラベルをストレージに追加で記憶することで、知識の追加・更新が可能となります(図2)。ニューラルネットワークのパラメータをいっさい調整し直さないことで、従来技術で課題となっていた破滅的忘却の問題を回避でき、高い精度を維持したまま知識の追加・更新が可能となります(図3)。

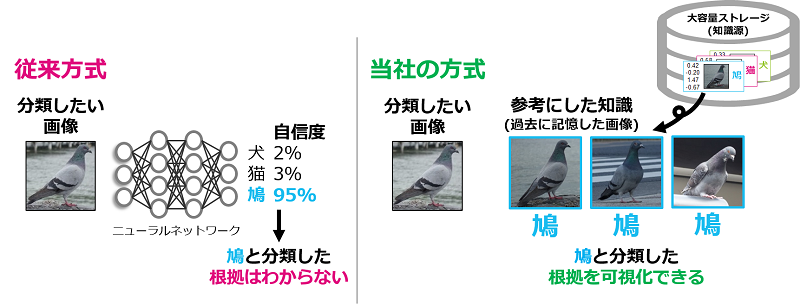

さらに、AIの説明可能性*2の改善やブラックボックス問題*3の緩和も期待できます。従来の方式では、ニューラルネットワークによって画像を分類した際に、結果に至るまでの過程や根拠を人間が解釈できる形で示すことはできませんでした。一方で、当社の方式では、画像を分類する際にストレージの中で参照されたデータを列挙することで、分類結果に対する根拠を可視化することができます(図4)。また、ストレージ内に記憶された知識ごとに参照された回数や時期を解析することで、知識ごとの有効性や需要を評価できるという特長もあります。

- 画像の特徴量 : ニューラルネットワークの演算を通して得られる多次元(例: 1,024次元)の数値データ

- AIの説明可能性 : AIが導き出した結果に対し、根拠や理由を人間が解釈できる形で説明可能かどうかを表す言葉

- ブラックボックス問題 : AIがどのような過程を経て予測結果に至ったかは人間にはわからず、ブラックボックスと化している問題

本成果は、コンピュータビジョン分野のトップの国際会議の1つであるECCV 2022 (European Conference on Computer Vision 2022)で発表しました[1]。

本稿は、文献[1]©2022 Springerから図面等一部抜粋&再構成したものです。

記載されている社名・商品名・サービス名などは、それぞれ各社が商標として使用している場合があります。

文献

[1] K. Nakata, Y. Ng, D. Miyashita, A. Maki, YC. Lin, J. Deguchi, “Revisiting a kNN-Based Image Classification System with High-Capacity Storage,” Computer Vision - ECCV, pp. 457-474, 2022.

[2] A. Radford, et al, “Learning Transferable Visual Models From Natural Language Supervision,” ICML, pp. 8748-8763, 2021.